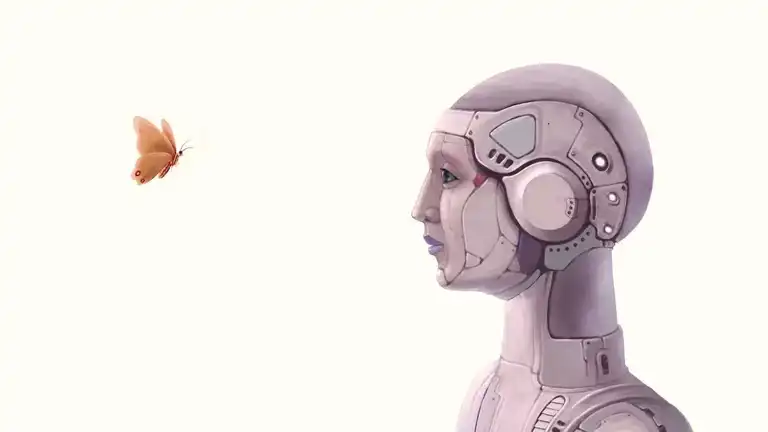

Yeni bir araştırma, ileri seviye yapay zeka modeli ChatGPT'nin insanlara özgü karar alma hatalarına ve önyargılara sahip olduğunu ortaya koydu. INFORMS dergisi Manufacturing & Service Operations Management'ta yayımlanan çalışma, yapay zekanın güvenilirliği konusunda önemli soruları gündeme getiriyor. Araştırmacılar, ChatGPT'yi 18 farklı önyargı testine tabi tuttular ve sonuçlar dikkat çekiciydi. Model, testlerin yaklaşık yarısında aşırı güven, kumarbaz yanılgısı ve belirsizlikten kaçınma gibi insan bilişsel tuzaklarına düştü. Bu durum, yapay zekanın mükemmel olmadığını ve insan benzeri hatalara açık olduğunu gösteriyor. Beklendiği gibi matematik ve mantık problemlerinde başarılı performans sergileyen ChatGPT, öznel yargı gerektiren durumlarda ise zorlandı. Riskli ancak potansiyel olarak daha karlı seçenekleri tercih etmek yerine, temkinli bir yaklaşım sergiledi ve kendi doğruluğunu abarttı. Hatta daha gelişmiş GPT-4 modeli bile yargı gerektiren görevlerde önyargılar sergiledi. Bu durum, yapay zekanın insan verilerinden öğrenme sürecinde bu önyargıları da devraldığını gösteriyor.

ChatGPT'nin İnsan Gibi Yanılgıları

İçindekiler

Yeni bir araştırma, ileri seviye yapay zeka modeli ChatGPT'nin insanlara özgü karar alma hatalarına ve önyargılara sahip olduğunu ortaya koydu. INFORMS dergisi Manufacturing & Service Operations Management'ta yayımlanan çalışma, yapay zekanın güvenilirliği konusunda önemli soruları gündeme getiriyor. Araştırmacılar, ChatGPT'yi 18 farklı önyargı testine tabi tuttular ve sonuçlar dikkat çekiciydi. Model, testlerin yaklaşık yarısında aşırı güven, kumarbaz yanılgısı ve belirsizlikten kaçınma gibi insan bilişsel tuzaklarına düştü. Bu durum, yapay zekanın mükemmel olmadığını ve insan benzeri hatalara açık olduğunu gösteriyor. Beklendiği gibi matematik ve mantık problemlerinde başarılı performans sergileyen ChatGPT, öznel yargı gerektiren durumlarda ise zorlandı. Riskli ancak potansiyel olarak daha karlı seçenekleri tercih etmek yerine, temkinli bir yaklaşım sergiledi ve kendi doğruluğunu abarttı. Hatta daha gelişmiş GPT-4 modeli bile yargı gerektiren görevlerde önyargılar sergiledi. Bu durum, yapay zekanın insan verilerinden öğrenme sürecinde bu önyargıları da devraldığını gösteriyor.

Yazılım Trendi, yazılım sektöründeki en son haberleri, incelemeleri ve rehberleri sunan, teknoloji meraklıları için bir kaynaktır. En yeni yazılım trendlerini, endüstri güncellemelerini ve uzman gö...

Yazılım Trendi, yazılım sektöründeki en son haberleri, incelemeleri ve rehberleri sunan, teknoloji meraklıları için bir kaynaktır. En yeni yazılım trendlerini, endüstri güncellemelerini ve uzman gö...